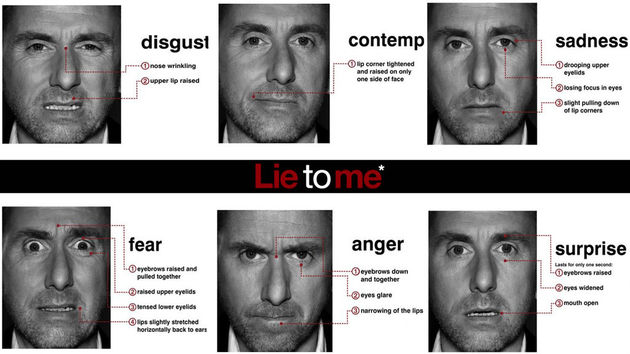

Ik kijk graag naar de Amerikaanse serie “Lie to me” waar een groep mensen gespecialiseerd is in het “lezen” van uitdrukkingen op de gezichten van mensen. En dan vooral de “micro-expressions”, de kleine trekjes in iemands gezicht die op een bepaalde emotie duiden. Wanneer je een tijdje zo’n serie volgt, ga je zelf ook veel meer op kleine details letten bij je gesprekpartner.

Interessante materie, daarom viel me vandaag een artikel in de New York Times op waarin geschreven wordt over de vorderingen die een aantal bedrijven maken die zich richten op het maken van algoritmes waarmee emoties kunnen worden “gelezen”.

Gelaatsuitdrukkingen blijken veelal universeel te zijn. De manier waarop mensen bij bepaalde emoties hun wenkbrauwen fronzen, hun neusgaten verwijden of met hun mondhoeken trekken is overal ter wereld min of meer gelijk en daar valt met slimme wiskunde een bepaalde wetmatigheid in vast te stellen.

Emotient en Affectiva, twee Amerikaanse bedrijven, zijn daar al enige tijd mee bezig. De afgelopen 2,5 jaar zijn via webcams ongeveer 1,5 miljard emotionele reacties van mensen verzameld die toestemming gegeven hadden om gefilmd te worden terwijl ze video’s bekeken. Deze gegevens worden als basis gebruikt om software te ontwikkelen waarmee gezichten “gelezen” kunnen worden.

Natuurlijk zijn er direct vragen over privacy en over toepassingen. Wat het eerste betreft wordt bij toepassingen als bijvoorbeeld voor Google Glass toegezegd geen opnames te maken van de gezichten waarvan de emoties worden geïnterpreteerd. Toepassingen zouden bedacht kunnen worden voor Google Glass, waardoor bijvoorbeeld mensen met bepaalde vormen van autisme geholpen kunnen worden bij het duiden van emoties. Maar ook bij overheidsinstanties die zich met veiligheidsissues bezighouden, zijn toepassingen (à la ‘Lie to me’) denkbaar.