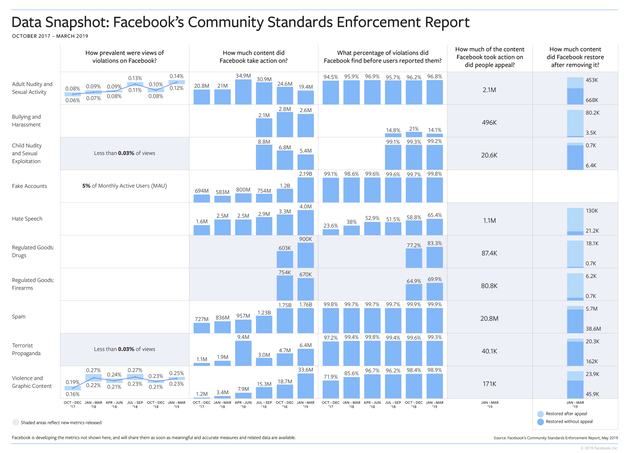

Facebook verwijderde in de eerste drie maanden van 2019 maar liefst 2,2 miljard nepaccounts van het sociale netwerk. Dat is een stijging van zo’n 400% ten opzichte van hetzelfde kwartaal in 2018 (583 miljoen) en meer dan een verdubbeling van Q4 2018 (iets meer dan een miljard). Het grootste gedeelte van de verwijderde accounts, worden al verwijderd binnen enkele minuten dat het is aangemaakt en hebben dus nog weinig schade aan kunnen richten.

In een nieuwe blogpost geeft Facebook’s hoofd Integriteitszaken Guy Rosen een update over hoe het bedrijf het doet wat betreft nepaccounts en het verwijderen van haatdragende boodschappen, seksueel getinte content, terroristische propaganda en andere content die niet op Facebook hoort.

Opvallend: een groot gedeelte van de content wordt al verwijderd voordat een gebruiker hier een melding van gedaan heeft.

Nog een aantal interessante cijfers:

– Voor iedere 10.000 views van content op Facebook, zijn er 11 tot 14 views die in overtreding zijn van Facebook’s regels wat betreft ‘Adult nudity & sexual activity’

– Voor iedere 10.000 views van content op Facebook, 25 views bevatten content die in gaat tegen de regels van geweld.

– 5% van de maandelijkse actieve accounts zijn nep.

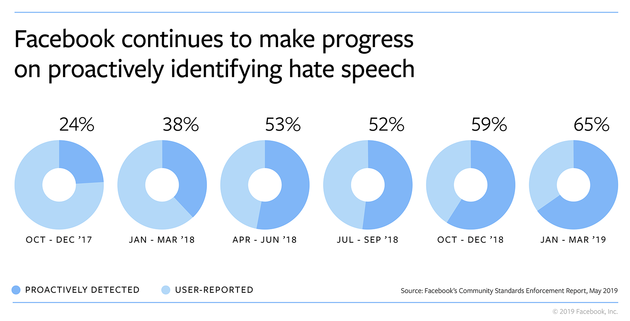

Ook goed om te zien is het feit dat de afgelopen twee jaar het opsporen van haat spraak aanzienlijk verbeterd is. Van 24% eind 2017 tot 65% in het eerste kwartaal van dit jaar. Facebook geeft wel aan dat het waarschijnlijk lastiger gaat worden om dit percentage hoog te houden, door nieuwe privacy maatregelen gaat het lastiger worden om content te beoordelen. Facebook zegt veel te investeren in nieuwe technologieën om content te beoordelen in alle talen en regio’s. Mark Zuckerberg: “I think the amount of our budget that goes toward our safety systems – I believe is greater than Twitter’s whole revenue this year. So we’re able to do things that I think are just not possible for other folks to do.”

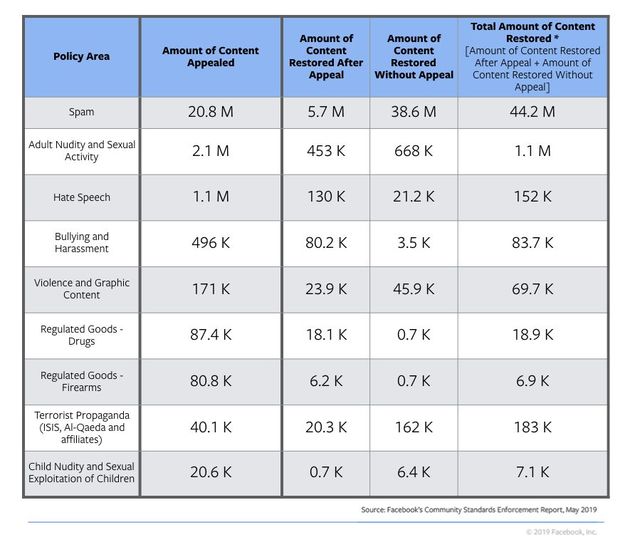

Facebook geeft aan dat ze nog niet perfect zijn op het gebied van opsporen van content die in overtreding is met de regels. Een gedeelte van de verwijderde content wordt dan ook later weer toegelaten, omdat het ‘vals alarm’ blijkt te zijn. Wanneer Facebook actie onderneemt en een bericht of account verwijdert, licht Facebook de betrokken persoon in. In de meeste gevallen geeft Facebook de persoon de mogelijkheid om zich te verweren.

Facebook is goed bezig met het detecteren van foto’s, maar tegen schokkende beelden in live video’s is nog geen goed plan van actie. Zo kon de schutter die in New Zeeland begin dit jaar 49 mensen vermoordde bij een moskee, hier live verslag van doen op Facebook.